技术速递|开启全新的多模态模型 - Microsoft Phi-4-mini & Phi-4-multimodal

作者:卢建晖 - 微软高级云技术布道师排版:Alan WangMicrosoft Phi-4 系列模型正式发布,延续先前发布的强推理 Phi-4 (14B)模型, 今天带来了 Phi-4-mini-instruct(3.8B),以及 Phi-4-multimodal(5.6B)模型。我们可以从 Hugging face、Azure AI Foundry Model Catalog、GitHub M

作者:卢建晖 - 微软高级云技术布道师

排版:Alan Wang

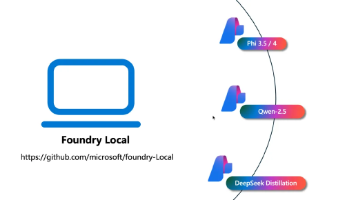

Microsoft Phi-4 系列模型正式发布,延续先前发布的强推理 Phi-4 (14B)模型, 今天带来了 Phi-4-mini-instruct(3.8B),以及 Phi-4-multimodal(5.6B)模型。我们可以从 Hugging face、Azure AI Foundry Model Catalog、GitHub Models,以及 Ollama 获取使用模型。

Phi-4 除了在多语言、推理以及数学等方面的能力提升外,对于大家期待已久的 Function Calling 也终于支持了。与此同时,Phi-4-multimodal 更是作为全模态模型,具备了视觉、听觉、文本、多语言理解、强推理,以及编码等能力。我们可以把 Phi-4-mini / Phi-4-multimodal 部署在边缘终端,让更多的 IoT 应用场景在算力和网络受限的情况下,可以和生成式人工智能结合。接下来,我们一起探索全新的 Phi-4-mini 以及 Phi-4-multimodal。

Function Calling

这是社区期待已久的功能,有了 Function Calling,我们可以对 Phi-4-mini / Phi-4-multimodal 的文本能力进行扩展,结合搜索引擎,以及连接不同的工具等。如图所示,这是一个通过 Phi-4-mini 查询英超比赛信息的示意图:

示例代码

量化后的模型部署

我们可以把量化后的模型部署在边缘设备中,并结合 Microsoft Olive, ONNXRuntime GenAI 把 Phi-4-mini 部署在 Windows、iPhone、Android 等终端上。以下是一个在 iPhone 12 Pro 上运行的示例:

iPhone 12 Pro 运行示例

全模态 SLM

Phi-4-multimodal 是全模态的模型,支持文字、视觉、语音输入。或许大家对视觉场景已经非常熟悉,我们可以根据图片,直接生成代码。

语音功能的整合让 Phi-4 在功能上有了更强的支持,以下是相关示例:

强推理性

Phi-4 (14B) 发布时,强推理性就是一个卖点,现在 Phi-4-mini 和 Phi-4-multimodal 虽然参数量减少了,但也具备了该能力,我们可以结合 Image 来测试强推理能力。例如上传一张图片,让 Phi-4-multimodal 能根据图片内容结合提示词更有序地生成项目代码。

Phi-4-mini 和 Phi-4-multimodal 在有限的参数量上达到了一些 LLM 的效果。我们可以把 Phi-4-mini 和 Phi-4-multimodal 部署在边缘端,让我们的 PC、移动设备、IoT 具备更强的生成式人工智能能力。我们会陆续在 Phi Cookbook(https://aka.ms/Phicookbook)增加示例, 希望 Phi Cookbook 能成为你使用 Phi-4 的必备指南。

学习资源

更多推荐

已为社区贡献49条内容

已为社区贡献49条内容

所有评论(0)